阿里巴巴集团近日正式上线图生视频模型Wan2.2-I2V-Flash,该模型在推理速度和生成效率方面实现重大突破。据官方数据显示,新模型较前代Wan2.1的推理速度提升12倍,指令遵循能力显著增强,可精准控制影视级运镜效果,同时保持输入图像的风格一致性。其定价策略为0.1元/秒,生成成功率提升123%,目前已在阿里云百炼平台开放API调用。

此次技术升级建立在7月28日开源的通义万相Wan2.2系列基础上。该系列包含三大核心模型:文生视频Wan2.2-T2V-A14B、图生视频Wan2.2-I2V-A14B及统一视频生成Wan2.2-TI2V-5B。其中前两者采用业界首创的MoE架构,通过高噪声与低噪专家模型协同工作,在27B总参数量下实现14B激活参数,计算资源消耗降低50%。5B版本则支持消费级显卡部署,以22G显存即可在数分钟内生成5秒720P高清视频,时空压缩比达4×16×16。

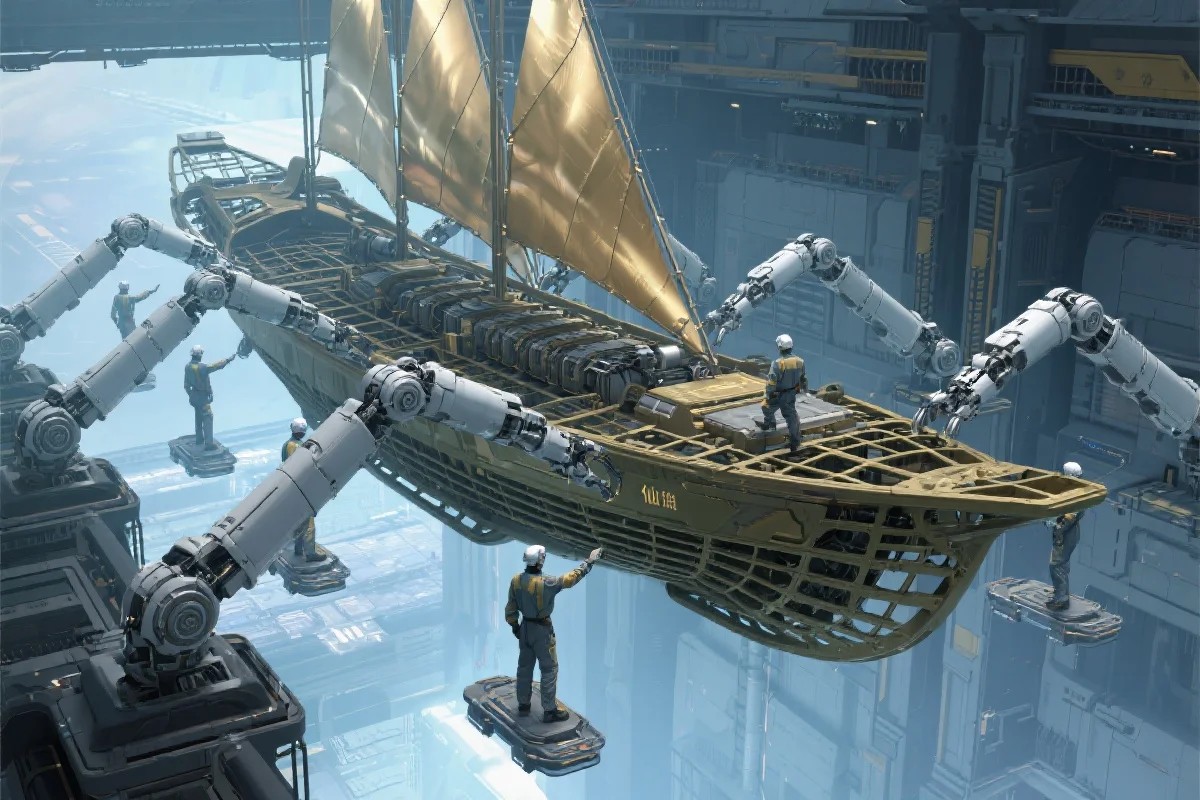

技术团队首创的电影美学控制系统成为亮点,将光影、色彩、镜头语言等影视元素编码为60余个可控参数。演示案例显示,模型能高度还原《星际穿越》等经典电影的视觉风格,在复杂运动生成、人物交互等维度表现突出。目前单次生成虽限于5秒时长,但支持通过多轮提示词迭代完成短剧制作。

行业观察人士指出,该技术突破将显著降低影视创作门槛,预计对动画短片、IP衍生内容等领域产生深远影响。随着模型持续迭代,单次生成时长有望进一步延长,推动AI视频生成技术向工业化生产迈进。

© 版权声明

文章版权归作者所有,未经允许请勿转载。