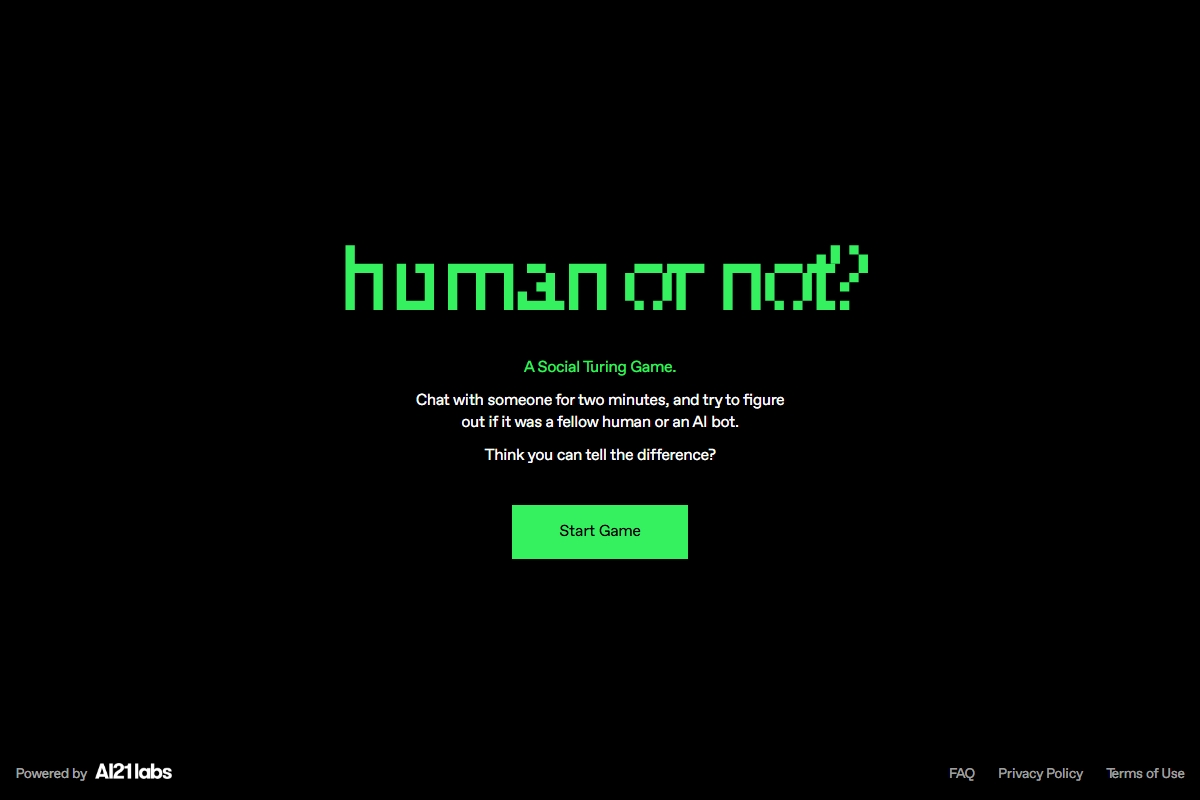

Human or Not? 是一个基于AI的在线互动游戏,旨在测试用户能否区分与之对话的对象是真人还是AI聊天机器人。该平台结合了自然语言处理(NLP)和人类行为分析,为用户提供了一种有趣的方式,来探索AI与人类交流的边界。

2. 核心功能

- 互动游戏:用户进入网站后,会与一个匿名对象进行限时对话(通常为2分钟),结束后需猜测对方是“Human”或“AI”。

- AI模型参与:部分对话由先进的AI驱动(如GPT类模型),模拟人类回答风格,增加辨别的难度。

- 数据统计:游戏结束后,网站会展示全球玩家的总体辨别正确率,揭示AI的“拟人化”程度。

3. 设计目的

- 公众教育:帮助普通人直观感受AI对话能力的进步,引发对AI伦理、隐私和未来人机交互的思考。

- 研究价值:可能用于收集人类与AI对话的行为数据,优化自然语言生成(NLG)技术。

- 娱乐性:以游戏形式让用户体验“图灵测试”的简化版,兼具挑战性和趣味性。

4. 技术背景

- 背后可能采用大语言模型(LLM)(如GPT-3.5/4、Claude等)模拟人类对话。

- 通过限制对话时间和话题,控制测试条件,避免AI暴露典型机器特征(如过长回复或绝对理性回答)。

5. 用户体验

- 简单易用:无需注册,点击即可开始游戏。

- 多语言支持:可能支持英语等多语言对话(取决于AI训练数据)。

- 社交分享:用户可分享自己的辨别结果,吸引更多人参与。

6. 潜在问题与争议

- 隐私风险:匿名对话可能涉及敏感内容,需注意数据收集政策。

- AI误导性:若AI过于逼真,可能加剧公众对“深度伪造”(Deepfake)技术的担忧。

- 文化偏差:AI训练数据可能导致对某些语言或文化群体的表现不均。

7. 类似平台

- Bot or Not?:早期AI辨别游戏。

- ChatGPT 对话测试:用户自建对比实验。

总结

Human or Not? 是一个兼具教育性和娱乐性的实验项目,反映了当前AI在模仿人类对话上的突破。它不仅是公众了解AI的窗口,也为开发者提供了改进AI自然交互的参考。用户可通过该网站直观体验“AI能否以假乱真”这一前沿议题。