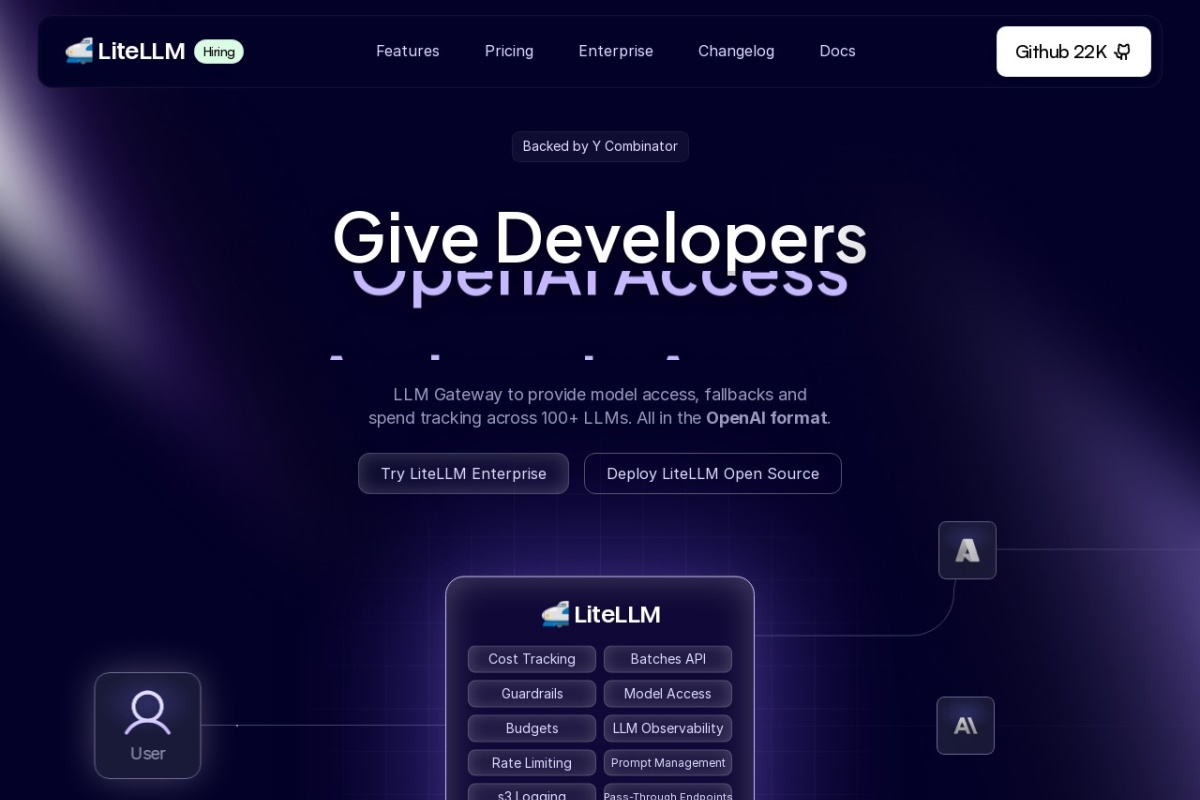

LiteLLM 是一个开源的大型语言模型(LLM)管理工具,旨在简化和标准化对多种 AI 模型的调用。以下是关于该网站的详细解读:

1. 核心功能

- 统一 API 接口:LiteLLM 提供与 OpenAI 兼容的 API 格式,支持调用超过 100 种大型语言模型,包括 OpenAI、Anthropic、AWS Bedrock、Cohere、HuggingFace 等。开发者无需为不同平台编写特定代码,只需通过 LiteLLM 的统一接口即可完成调用。

- 负载均衡与异常处理:支持智能路由和负载均衡,可自动将请求分配到最优模型,并在模型故障时实现无缝回退(fallback),确保服务稳定性。

- 性能优化:提供速度追踪、限速管理和配置管理功能,帮助开发者优化模型调用效率。

2. 技术特点

- 多模型支持:兼容同步和异步调用,支持流式输出,适用于需要实时反馈的应用场景。

- 标准化输出:无论调用何种模型,返回结果均遵循统一的格式(如 OpenAI 的

choices 结构),简化后续数据处理。

- 扩展性:可通过 Python SDK 或 REST API 集成到现有系统中,支持本地部署和云端模型混合使用。

3. 适用场景

- 多模型代理:适合需要同时调用多个 AI 平台的企业或开发者,例如构建 AI 聊天系统(如结合 NextChat 部署多账号服务)。

- 开发工具集成:可与 Langchain 等框架配合,简化复杂 AI 工作流的实现。

- 成本与性能优化:通过负载均衡和 fallback 机制,降低 API 调用成本并提升响应速度。

4. 开源与社区

LiteLLM 由 BerriAI 团队开发,项目完全开源,社区活跃,持续更新模型支持和功能优化。开发者可通过 GitHub 参与贡献或查阅文档。

5. 局限性

- 部分高级功能(如细粒度路由策略)可能需要额外配置。

- 对本地模型的支持依赖第三方工具(如 Ollama),需自行部署。

总结

LiteLLM 是面向开发者的高效工具,通过抽象化底层模型差异,降低了多模型管理的复杂度,尤其适合需要灵活调用不同 AI 服务的场景。其开源特性也使其成为自定义 AI 解决方案的理想选择。如需进一步了解,建议直接访问官网或查阅项目文档。