deepseek开放平台

DeepSeek开放平台(https://platform.deepseek.com)是一个基于前沿人工智能技术的综合性AI服务平台,由深度求索(DeepSeek)团队开发。

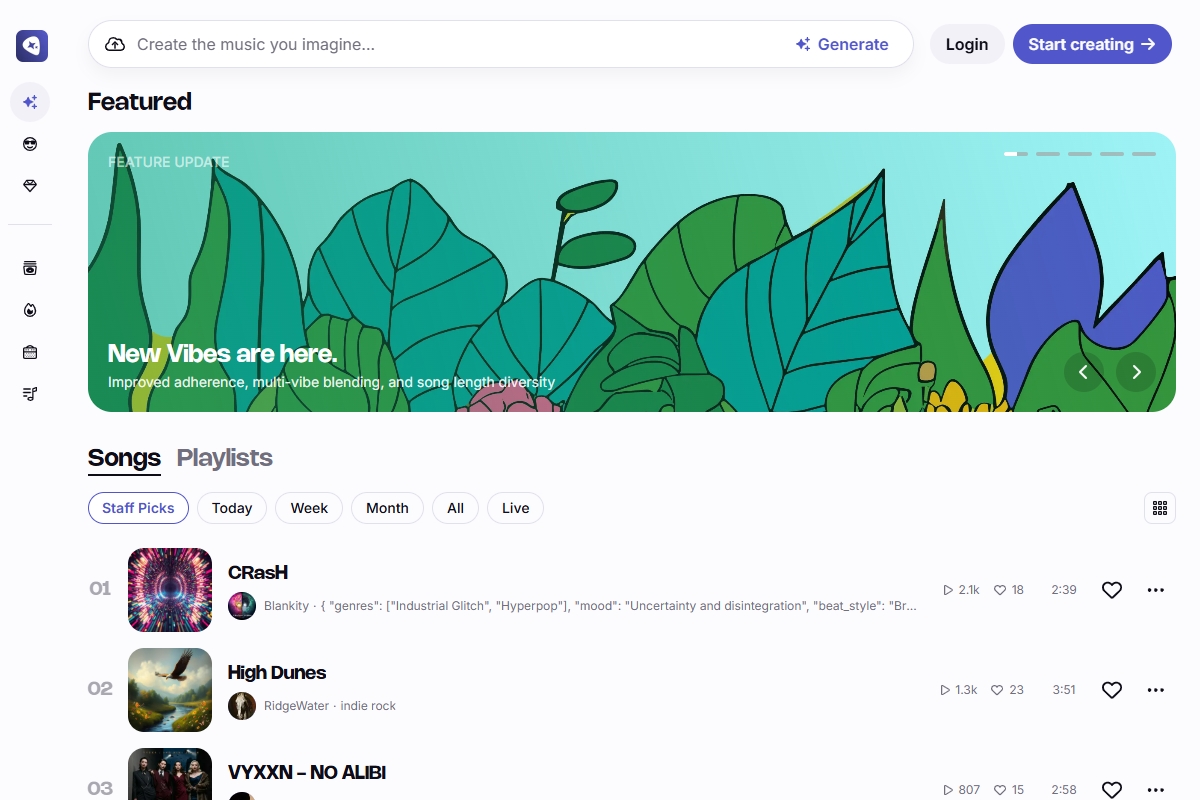

Riffusion是一款基于人工智能技术的开源音乐生成工具,由Seth Forsgren和Hayk Martiros开发,其核心技术结合了Stable Diffusion模型与音频频谱图转换,实现了通过文本描述生成音乐的功能。以下是对该平台的全面解析:

模型架构

Riffusion采用改进的Stable Diffusion模型,通过微调使其能够处理音频频谱图(声音频率随时间变化的可视化表示)。生成过程中,系统首先将文本提示转化为频谱图图像,再通过声码器将图像转换为可播放的音频波形。

创新性方法

区别于传统音乐生成模型直接输出音频,Riffusion利用视觉-听觉的跨模态转换,实现了对音乐风格、情感和乐器的精细控制。用户可通过调整参数(如采样步数、去噪强度)优化输出效果。

优势:

– 开源生态:代码完全公开,开发者可二次开发或集成至其他应用。

– 低门槛:无需音乐理论或编程知识,通过网页端即可操作。

– 多平台支持:提供Web应用、Python库及API接口,适配不同使用场景。

局限性:

– 音频质量:输出音质低于专业录音室水平,人声生成可能存在发音瑕疵。

– 创作深度:生成的音乐缺乏人类作曲的情感复杂性,更适合草图式创作。

bash

git clone https://github.com/riffusion/riffusion-hobby.git

cd riffusion-hobby

pip install -r requirements.txt

python -m riffusion.streamlit.playground