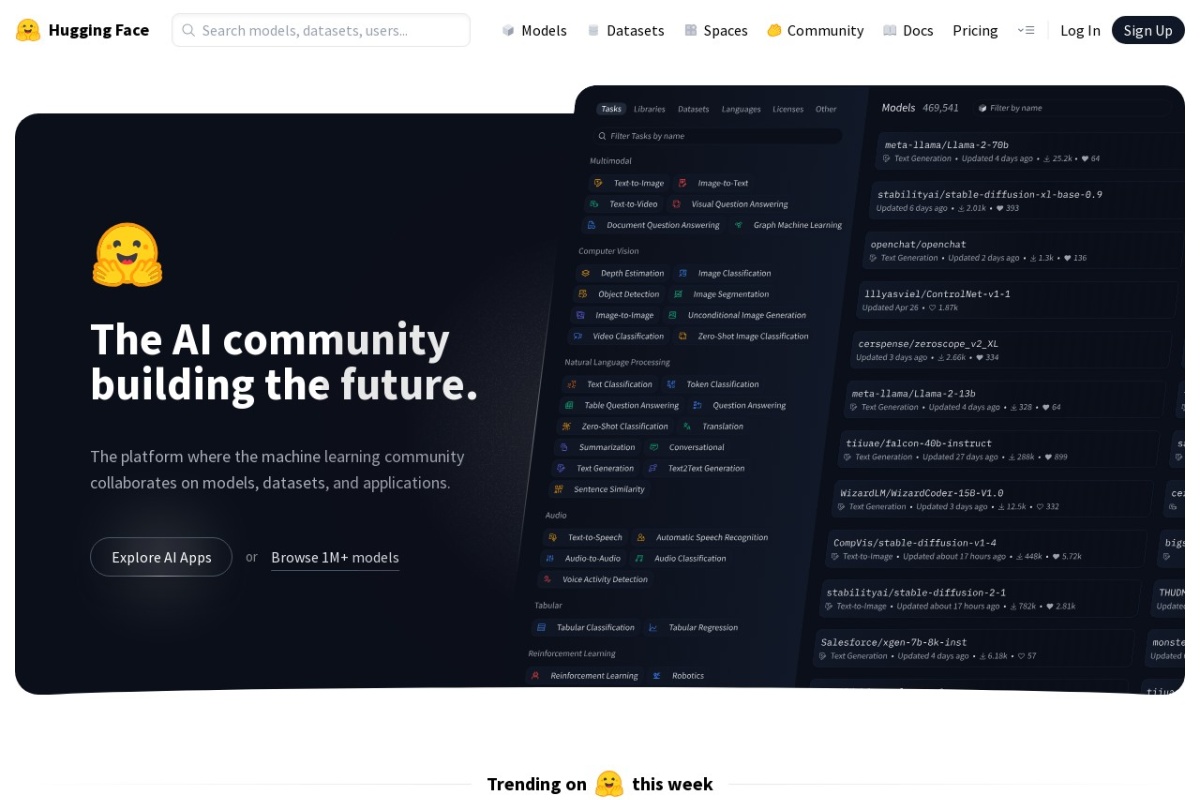

Hugging Face( https://www.huggingface.co )是一个以自然语言处理(NLP)为核心的人工智能开源社区和平台,致力于推动机器学习技术的民主化与协作创新。以下从多个维度对其核心功能与生态进行系统解析:

1. 平台定位与发展历程

- 起源:成立于2016年,最初开发聊天机器人,后因开源Transformers库在机器学习领域迅速崛起,现已成为全球最大的AI模型共享平台之一,被类比为“机器学习界的GitHub”。

- 使命:通过开源工具降低AI技术门槛,促进研究与应用的无缝衔接。

2. 核心组件与功能

- Transformers库:

支持BERT、GPT等Transformer架构的预训练模型,提供统一的API接口,覆盖文本生成、翻译、情感分析等任务。用户可直接调用模型推理或进行迁移学习。

- Datasets平台:

集成超4万个高质量数据集,涵盖多语言、多模态数据,支持一键加载与预处理,显著简化数据 pipeline。

- Model Hub:

托管超23万个开源模型(截至2024年数据),包括NLP、CV、语音等领域,支持版本管理与社区协作。

- Spaces:

允许用户部署和共享交互式AI应用(如Demo、API),内置GPU支持,可直接展示模型效果。

3. 技术生态与工具链

- 关键工具包:

transformers:模型加载与训练的核心库。

datasets:高效数据处理。

tokenizers:高性能文本分词。

diffusers:扩散模型(如Stable Diffusion)支持。

accelerate:简化分布式训练。

- 集成框架:兼容PyTorch、TensorFlow,支持混合精度训练与模型量化。

4. 用户实践指南

- 快速入门:

- 安装依赖:

pip install transformers datasets huggingface_hub

- 模型调用:通过

pipeline()函数实现零代码推理。

- 模型共享:

用户可上传微调后的模型至Model Hub,支持版本控制与文档自动生成。

- 资源访问:

- 国内镜像(hf-mirror.com)加速下载,但登录需国际网络环境。

- 通过Access Token(需在Settings中生成)授权模型访问权限。

5. 社区与协作价值

- 开放文化:鼓励开发者贡献模型、数据集及代码,形成正向反馈循环。

- 教育资源:提供详细文档、教程及Colab示例,降低学习曲线。

- 行业影响:已成为工业界与学术界模型部署的首选平台,推动AI技术标准化。

6. 扩展应用场景

- 多模态支持:逐步扩展至图像、音频处理(如Whisper语音模型)。

- 企业服务:提供付费的Inference API和训练加速服务,支持商业化需求。

总结

Hugging Face通过构建工具、数据、模型三位一体的生态系统,彻底改变了AI开发范式。其核心优势在于开源协作、易用性及前沿技术的快速集成,适合研究者、工程师及爱好者探索最先进的AI解决方案。对于中文用户,建议结合镜像站与工具加速访问以提升体验。